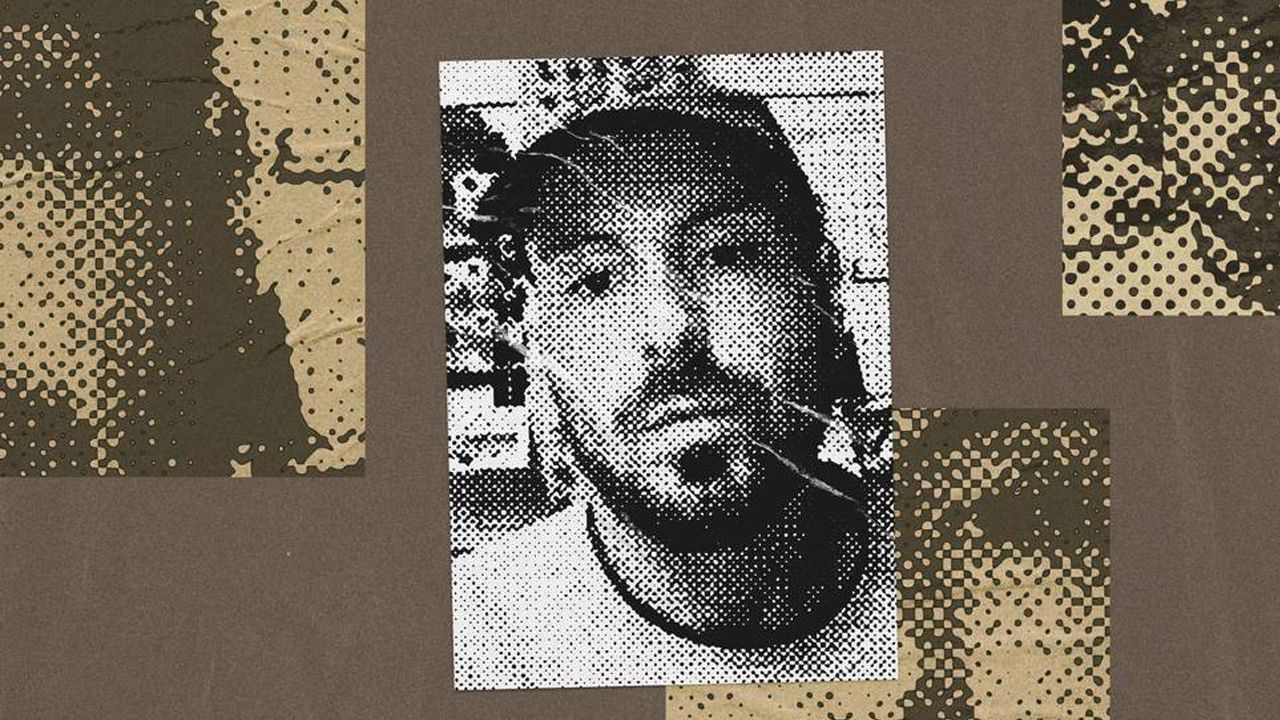

Yapay zekâ karşıtı aktivist Sam Kirchner, iki haftayı aşkın süredir kayıp. San Francisco Emniyeti, Kirchner’in silahlı ve tehlikeli olabileceği uyarısında bulundu; OpenAI, olası tehdit nedeniyle ofislerini geçici olarak kapattı. Oysa Kirchner’i tanıyan birçok aktivist için o, kısa süre öncesine kadar “kararlı ama barışçı” bir figürdü.

TRAVİS HAVA ÜSSÜ’NDEN BERKELEY TOPLANTILARINA

Uzun yıllardır sokak eylemlerine katılan aktivist Phoebe Thomas Sorgen, Kirchner’le ilk kez San Francisco’nun kuzeydoğusundaki Travis Hava Üssü önündeki bir protestoda tanıştı. Eylem, ABD’nin göçmenlik politikaları ve İsrail’e askerî yardımı hedef alıyordu.

Sorgen ve kendisi gibi daha ileri yaşlardaki altı kadın, üssün girişini bloke etmeyi planlıyordu. Kirchner, 27 yaşında, yeni kurulmuş “Stop AI” adlı grubun birkaç üyesiyle birlikte oradaydı. Onların görevi, olası polis müdahalesini telefonlarıyla kaydetmekti.

Sorgen, Stop AI üyelerinin asıl amacının “süper yapay zekâyı durdurmak için kitlesel, şiddetsiz sivil itaatsizlik” yapmaya gönüllü insanları bulmak olduğunu söylüyor ve bunu “akıllıca bir strateji” olarak niteliyor. Bu tanışmanın ardından Berkeley’deki Stop AI toplantılarına katılmaya başlayan Sorgen, hem yapay zekâ endüstrisi hem de grup hakkında daha fazla şey öğrenmiş ve davayı benimsemiş.

Stop AI, yapay “süper zekâ” geliştirilmesinin dünyada kalıcı olarak yasaklanmasını savunan, bu alandaki diğer birçok örgüte göre daha radikal bir yapı. Üyeleri tutuklanma riskini göze almaya daha açık, ama aynı zamanda her toplantıda şiddetin hem ahlaki hem de stratejik açıdan yanlış olduğu vurgulanıyor. Signal üzerindeki örgütçi sohbetlerinde, şiddete dair espri ya da ima dahi yapanlar bir kez uyarılıyor; tekrar edenler hemen uzaklaştırılıyor.

YOĞUN KAYGI, TÜKENEN SABIR

Seattle’dan San Francisco’ya taşınan ve Stop AI’nın oradaki örgütlenmesini başlatan Kirchner, kamuya açık açıklamalarında defalarca şiddetsizliğe bağlılığını dile getirdi. Arkadaşları onu “samimi bir pasifist” olarak tanımlıyor.

Ancak aynı zamanda, insanlardan daha zeki bir yapay zekâ geliştirilmesinin “çok yakın” ve “neredeyse kesin şekilde insan soyunun sonu” olacağına inanıyordu. Yakın çevresine sık sık, olası bir yapay zekâ felaketinde kız kardeşinin öldürülebileceğinden bahsediyordu. Bu varoluşsal kaygının, ruh hâlini ağır biçimde etkilediği aktarılıyor.

“Üzerinde inanılmaz bir ağırlık vardı,” diyor Stop AI’nın çekirdek organizatörlerinden Wynd Kaufmyn. “Sanki dünyanın yükünü tek başına taşıyormuş gibiydi.”

Grubun içinde bazıları, bu yoğunluğun zaman zaman “dogmatik ve sabırsız” bir tavra dönüştüğünü söylüyor. Sorgen, Kirchner’le ara ara sakinleşmesi, nefes alması gerektiği üzerine konuştuğunu anlatıyor: “Türleri yok olma tehdidi altında görmek, bunun ‘bayağı muhtemel’ olduğunu düşünmek, duygusal olarak çok yıpratıcı.”

TARTIŞMA, İDDİA EDİLEN SALDIRI VE KAYBOLUŞ

Kırılma noktası, Stop AI’nın bir planlama toplantısında geldi. Kaufmyn ve grubun yeni seçilen lideri Matthew Hall’un (takma adıyla “Yakko”) anlattığına göre, bir Pazar günü yapılan toplantıda Kirchner, yaklaşan bir eylem için kullanılacak mesajların ifadesi üzerine sert bir tartışmaya girdi. Toplantı dağıldı, Kirchner ise kendi fikrini tek başına hayata geçireceğini söyleyerek ayrıldı.

Aynı akşam yaşananlar, bugün hem Kirchner’in kayboluşunun hem de “tehlikeli olabilir” uyarılarının temelini oluşturuyor. Yakko’nun anlatımına göre Kirchner, ondan Stop AI’nın fonlarına erişim talep etti. Yakko, “O hâlini görünce bu parayı ne için kullanabileceğinden endişelendim” diyor. Talebi reddedince, Kirchner’in kendisine defalarca kafa ve yüz bölgesine vurduğunu, acil servise gidip beyin sarsıntısı açısından muayene edildiğini söylüyor. (Yakko, hastane çıkış raporunu da gazeteciyle paylaşmış durumda.)

Ertesi sabah Kirchner’in özür dilediği, ancak kafasının karışık göründüğü aktarılıyor. Yakko, “Şiddetsizliğin işe yaramadığını, hareketin çok yavaş ilerlediğini söyledi. Kelimesi kelimesine, ‘Benim için şiddetsizlik gemisi çoktan kalktı’ dedi,” diye anlatıyor.

Bu olayın ardından Stop AI üyeleri San Francisco polis hattını arayarak Kirchner’in ileride ne yapabileceğine dair kaygılarını iletmiş, ancak ilk aşamada somut bir adım atılmamış.

Grup, krizi bir süre kendi içinde yönetmeye çalıştı. Kirchner’in Stop AI’da kalması artık mümkün değildi, ama durum kontrol altında görünüyordu. Tablo, Şubat ayında OpenAI ofislerinin kapılarını bloke ettiği gerekçesiyle açılan davada görülecek duruşmasına gelmemesiyle değişti. Üyeler, Kirchner’in Oakland’daki evine gidip kapının kilitsiz olduğunu, içeride kimsenin bulunmadığını gördü. Laptopu ve telefonu evdeydi; bisikleti ise kayıptı. Bunun üzerine hem polisi hem de bazı büyük yapay zekâ şirketlerini yeniden haberdar ettiler.

Grup içindeki genel kanaat, Kirchner’in bir yerde kamp yapıyor olabileceği yönünde. Yakınları, onun hem yaşanan olaylardan ötürü incinmiş ve ihanete uğramış hissedebileceğini, hem de olası sonuçlardan korktuğunu düşünüyor. Bazıları, ağır bir ruhsal kriz yaşadığından endişe ediyor.

OPENAI ALARMA GEÇTİ, POLİS “SİLAHLI VE TEHLİKELİ OLABİLİR” UYARISI YAPTI

21 Kasım Cuma sabahına karşı saat 04.00’te Kirchner, X hesabından “Artık Stop AI’nın bir parçası değilim” mesajını paylaştı. Aynı gün, Wired’ın haberine göre OpenAI, San Francisco’daki ofislerini geçici olarak kapatma kararı aldı. Şirkete göre Kirchner, OpenAI çalışanlarına fiziksel zarar verme “niyetini dile getirmişti”.

San Francisco Standard’ın ortaya çıkardığı polis bültenine göre, 21 Kasım’da SFPD içinde dağıtılan bir iç yazışmada, iki ayrı ihbarcının Kirchner’in “yüksek güçlü silahlar alıp OpenAI’de insanları öldürmekten” bahsettiğini söylediği yer alıyor.

Ancak Stop AI cephesinde bu iddialar soru işaretiyle karşılanmış durumda. Yakko, “Bilgim dâhilinde Sam, OpenAI’ye ya da herhangi birine doğrudan bir tehditte bulunmadı,” diyor. Ona göre Kirchner’in ciddi bir eylem için kullanabileceği kayda değer bir maddi kaynağı da yok. Yine de grup, en kötü senaryo ihtimalini tamamen göz ardı etmek istememiş.

San Francisco Emniyeti, bültenle ilgili yorum yapmayı reddetti; OpenAI ise soruları yanıtsız bıraktı.

HAREKET İÇİNDEN TOPLU ŞİDDET KARŞITI AÇIKLAMALAR

Kirchner olayı ortaya çıkar çıkmaz, yapay zekâ güvenliği hareketi içindeki pek çok kişi ve örgüt şiddeti açıkça reddeden açıklamalar yaptı. Stop AI’dan daha büyük bir ağ olan PauseAI, Kirchner’den özellikle uzaklaştığını duyurdu.

PauseAI, taktikleri açısından daha uzlaşmacı bir profil çiziyor. Grup, şiddet kapsamına sadece fiziksel saldırıyı değil, mülke zarar vermeyi de dâhil ediyor. Gönüllülerin kanunsuz ya da “aşırı” eylemlere — kapıları zincirlemek, girişleri barikatlamak, şirketlerin faaliyetlerini fiilen engellemek gibi — katılmasına izin verilmiyor. “Bizim yaptığımız protestolar genelde insanların aynı yerde durup mesaj vermesi şeklinde,” diyor PauseAI CEO’su Maxime Fournes. “İnsanların işe gitmesini engelleyen ya da yolları kapatan eylemler yapmıyoruz.”

Stop AI ise tam da bu çizgiyi fazla “nazik” bulan aktivistlerin PauseAI Discord sunucusunda bir araya gelmesiyle doğmuş. Grup, Gene Sharp’ın 1973 tarihli “The Methods of Nonviolent Action” (Şiddet Dışı Eylem Yöntemleri) kitabını referans alıyor; oturma eylemleri, “şiddetsiz engelleme” ve “hapsi göze alma” gibi daha çatışmalı taktiklerden çekinmiyor.

“DURDURMAK” MI, “ARA VERMEK” Mİ?

PauseAI, süper zekâ alanındaki gelişmelerin “demokratik olarak belirlenmiş güvenli çerçeveler” oluşturulana kadar duraklatılmasını savunuyor. Stop AI ise bu tür bir güvenli “uyum” (alignment) fikrini hayal ürünü olarak görüyor ve insanüstü zekâya giden her türlü ilerlemenin tamamen yasaklanmasını istiyor.

Bu fark, kullandıkları dilde de belirgin. Fournes, “Resmî PauseAI kanallarında ‘Hepimiz kesin olarak öleceğiz’ gibi ifadeler görmezsiniz,” diyor. Stop AI’nın mesajları ise daha sert: Geçen Ekim ayında San Francisco’daki OpenAI ofislerinin kapılarını barikatlamayı planlarken gönderilen basın bülteninde, “OpenAI insanlardan daha zeki bir şey inşa etmeye çalışıyor ve bu hepimizi öldürecek!” ifadesi yer alıyordu. Daha yakın tarihteki bir dijital afişte, “OpenAI’yi kapatın, yoksa hepimiz öleceğiz!” sloganı kullanıldı.

Grubun çevirim içi topluluğunda bulunan 47 yaşındaki aktivist Jonathan Kallay, Stop AI’nın farklı kaygıları olan “büyük ve çeşitli” bir kitleyi bir araya getirdiğini söylüyor: İş kaybı, çevresel etkiler, yaratıcı hakların ihlali, vb. Ancak hepsi, “insanlığın yakın yok oluş ihtimali”ni merkeze alan bir hareketin parçası olduklarının farkında.

Yeni lider Yakko, grubun tonunu daha umutlu bir çizgiye çekmek istiyor. Ona göre, Kirchner’le yaşanan kopuşun nedenlerinden biri de buydu: “Sam, kıyamet söylemini yumuşatmak istememizin ihanet olduğunu düşündü ve korktu.”

“KIYAMET DİLİ” ŞİDDETE KAPI AÇAR MI?

Yapay zekâ geliştirilmesinin etik ve siyasi riskleri etrafında dönen tartışmalarda, Stop AI yalnız değil. Bir yandan da hareketin içinde “nasıl konuşmalı?” sorusu büyüyor.

Felsefeci ve tarihçi Émile P. Torres, Kirchner’le arkadaşlık etmiş ve Stop AI’nın yaz eylemlerinden birine katılmış bir isim. Torres, tanınmış “AI kıyametçisi” Eliezer Yudkowsky’yi, süper zekâyı durdurmak için kaç kişinin ölmesinin “etik olarak kabul edilebilir” olabileceği yönündeki düşünce deneyleri nedeniyle eleştiriyor. Aynı zamanda Kirchner ve Stop AI liderlerini, “insanlığın yok oluşunu neredeyse kesin son” olarak anlatan mesajlarını yumuşatmaları için uyarmış: Ona göre bu tür söylemler, hem şiddeti meşru gösterebilir hem de bazı insanları akıl dışı davranışlara itebilir.

Torres, yapay zekâ yüzünden dünyanın sonunun geldiğine inanan ve zamanla bir kült hâline dönüştükten sonra birkaç cinayetle ilişkilendirilen bir grubun varlığını hatırlatıyor (cinayetlerin doğrudan AI’la ilgisi olmasa da).

“İnsanları bir tür kıyamet zihniyetine sokan bir dil bu,” diyor. “Mesele, ‘oyunun adı’ nüfusun geleceği olunca, tek tek insan hayatları gözden çıkarılabilir gibi görünmeye başlıyor.” Torres, özellikle “uzun vadeciliği” (longtermism) yanlış yorumlayıp, bugünkü şiddeti gelecekteki olası yok oluşa karşı bir nevi “ahlaki yatırım” gibi sunan rasyonalist çevrelerden endişe ettiğini belirtiyor.